Aprendizagem de máquina e o Nobel de Física de 2024

Texto: Sílvio Dahmen, docente no Departamento de Ciências Naturais, Matemática e Educação do Campus Araras da UFSCar (DCNME-Ar)

O Prêmio Nobel de Física deste ano foi uma surpresa para muitos especialistas, uma vez que premiou dois cientistas – um físico e um da área de Ciência da Computação – por suas “descobertas fundamentais e invenções que possibilitaram o aprendizado de máquina utilizando redes neurais artificiais”. Em uma época em que a Inteligência Artificial (IA) está tão em voga, em particular os Modelos de Linguagem de Larga Escala (LLM, do Inglês Large Language Models), não deveríamos nos surpreender tanto: os LLMs, cujo exemplo mais conhecido é o ChatGPT, são sistemas de aprendizagem de máquina que utilizam modelos de Aprendizagem Profunda (deep learning) para compreender e gerar textos.

Mas o que redes neurais têm a ver com isso? A história é longa: em 1943, o neurocientista Warren McCulloch e o lógico (e criança prodígio) Walter Pitts publicaram um artigo intitulado “A Logical Calculus of Ideas Immanent in Nervous Activity”, onde pela primeira vez se propunha um modelo matemático para o funcionamento dos neurônios. Em 1949, o psicólogo Donald Hebb propôs um mecanismo para explicar o aprendizado e a memória, onde a ativação repetida e simultânea de dois neurônios levava a um reforço da sinapse entre eles. Estavam assim dados os fundamentos sobre os quais John J. Hopfield e Geoffrey E. Hinton, os ganhadores do Prêmio Nobel de Física de 2024, iriam construir seu edifício.

Hopfield, um físico teórico, é um dos mais conceituados pesquisadores na área de Física Biológica. Em 1982, ele publicou um famoso artigo onde propunha um modelo dinâmico de memória associativa baseado em redes neurais.

Mas o que são memórias associativas? Pensemos em um exemplo simples: ao tentarmos nos lembrar de uma palavra que está “na ponta da língua” mas não nos vem à mente no momento, associamos outras palavras àquela que queremos nos lembrar e que normalmente começam com as mesmas sílabas ou estão associadas a ideias semelhantes.

Como era mesmo o nome daquela fruta azeda, muita parecida com uma nêspera, cujo nome lembra outra fruta? Uvaia.

Isto acontece também quando queremos nos lembrar de uma palavra em um idioma estrangeiro. Você se lembra como se diz “bigorna” em Inglês? Obviamente é uma palavra pouco usual, mas se um dia você se deparou com a expressão idiomática “between the hammer and the anvil” (o nosso “entre a cruz e a espada”), talvez se lembre da palavra pela associação a situação difícil.

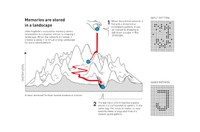

A memória associativa funciona como se nossa memória fosse representada pela topologia de uma região montanhosa, onde nos vales se encontram as palavras. Quanto aterrissamos num ponto mais alto, nossa memória passeia pelos diferentes vales, convergindo para aquele que procuramos. Essa topografia é o que os físicos chamam de “energy landscape”, onde os pontos mais baixos correspondem às regiões de estabilidade. Quanto a rede é treinada, ela gera uma paisagem semelhante a essa e, partindo de um ponto mais alto, converge para o vale mais profundo, que corresponde à palavra (ou imagem) que reconhecemos.

O modelo dinâmico de memória associativa proposto por Hopfield leva hoje seu nome. A questão da qual ele partiu e procurou responder foi a seguinte: teriam fenômenos coletivos em sistemas físicos, comuns no magnetismo, um correspondente em grandes redes de neurônios? Em outras palavras: se fenômenos coletivos emergentes de um grande número de neurônios poderiam dar origem a habilidades computacionais. Normalmente, em física do estado sólido, fenômenos coletivos são bastante robustos e tendem a não serem impactados por mudanças nos detalhes dos modelos. Isto leva à ideia de universalidade, um termo muito querido dos físicos e que remete à ideia de uma física subjacente que unifica diferentes fenômenos. Universalidade é um tema recorrente na Física Estatística, a área de Física da qual redes neurais fazem parte. Uma das grandes sacadas de Hopfield foi utilizar uma rede de neurônios binários, ou seja, em que cada neurônio podia estar em dois estados: 0 ou 1. Com isso foi possível usar toda a linguagem de sistemas clássicos de spins da Mecânica Estatística e trazer toda uma pletora de resultados para aperfeiçoar os modelos. Em outras palavras, a estrutura básica de redes neurais tem grande semelhança com modelos de spins da Mecânica Estatística aplicados ao magnetismo.

Pouco depois, Geoffrey Hinton e colaboradores generalizaram as ideias de Hopfield incorporando a ideia de variáveis estocásticas, ou seja, um sistema baseado em distribuições estatísticas de padrões neuronais, diferente do modelo de Hopfield, que se baseia em padrões individuais de neurônios. O modelo introduzido por Hinton veio a ser conhecido como “máquina de Boltzmann”.

As redes de neurônios artificiais tornaram-se um importante instrumento de análise de grande quantidade de dados em diferentes áreas da Física, dos fenômenos em escala microscópica (física de partículas) até aqueles em escala macroscópica (astrofísica). Do ponto de vista mais aplicado, grande parte dos trabalhos foi desenvolvida por cientistas da computação, que criaram algoritmos e métodos que hoje usamos em aplicações do dia a dia: reconhecimento e processamento de imagens, processamento de linguagem e análise de dados clínicos de pacientes, por exemplo. As redes neurais permitiram assim que uma ideia antes restrita à Física pudesse ser estendida a fenômenos da vida, como no caso das aplicações médicas, até a computação de alto desempenho. As redes neurais permitiram o advento da área de aprendizagem de máquina e, sem elas, não teríamos hoje os LLM como o ChatGPT.

O Prêmio Nobel reconheceu, este ano, o esforço de dois pioneiros cujos trabalhos foram além das fronteiras da ciência pura e que têm hoje um enorme impacto na vida das pessoas.